第1部<総論>

ネット企業が先導する

ハードウエアの技術革新

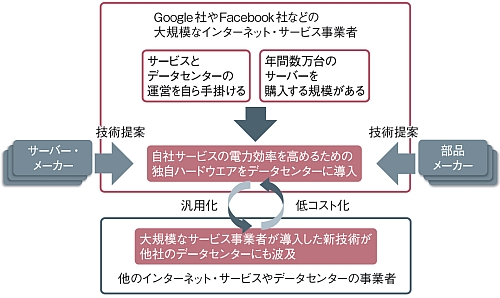

データセンターの技術革新の主役が、Google社やFacebook社などのネット企業に移りつつある。自社のサービスを高い電力効率で実現する必要に迫られたからだ。ネット企業とメーカーによる「協奏曲」が、データセンターを舞台に鳴り響く。

「Google」「Amazon.com」に「Facebook」──。ネット企業、とりわけ大規模なインターネット・サービスの事業者が、データセンター内のハードウエアの技術革新の主役に躍り出た。これらの企業が自社サービスの特性に合わせた独自のハードウエアを大量に導入するようになり、そこに多くのメーカーが群がっている。「データセンターの技術革新に関わる、特に米国内の動きは熱狂的だ」(あるサーバー・メーカー)。

流れを決定付けたFacebook

「データセンター協奏曲」ともいうべき熱狂の中心にいるのが、米Google社と米Facebook社である。Google社は2009年に、電源ユニットを冗長化せずにUPS(無停電電源装置)代わりの2次電池を配置した独自設計のサーバーを大量に導入していることを明らかにした。

そして2011年には、Facebook社が「Open Compute Project」(以下、OCP)の設立を発表した。自社が要求するサーバー・ラックやサーバー用マザーボードのハードウエア仕様をOCPで公開し、それに合わせて機器を開発することをサーバーなどのメーカーに求めた。

狙いはハードと運用のコスト減

これは、一部のインターネット・サービス事業者がデータセンターの技術革新を主導する形に変わったことを象徴する事実だ。まず、データセンター内の機器や設備を大量に購入する事業者が要求仕様を公開することで多数のメーカーが集まる。そして、同じ仕様を他の事業者が採用することでハードウエアが汎用品化する。これによってさらなる量産効果が生まれ、仕様策定を主導した事業者が、より安価に機器や設備を導入できる。こうしたサイクルが回り始めたのである。

第2部<空調・配電編>

高効率空調と直流給電を導入

再生可能エネルギーも視野に

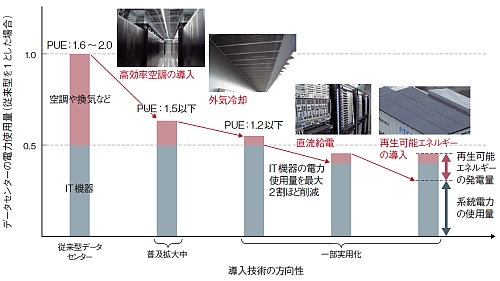

データセンターでは、空調などまだまだIT機器以外の電力が占める割合が大きい。これを減らすべく、高効率空調や外気冷却などを積極導入する動きが本格化している。配電時の電力損失低減や再生可能エネルギー導入に向けた取り組みも始まりつつある。

データセンターの使用電力の削減に向けた動きが世界的に加速している。中でも、米Facebook社が米国オレゴン州Prinevillで2011年4月に稼働を開始したデータセンターでは、PUE(power usage effectiveness)が1.07という驚異的な数値を達成した。

Facebook社の場合、サーバーの筐体を1.5Uの独自設計とし、ファンを大口径化した。さらに、冷却のためのエアコンを廃止し、「ミスト冷却」という外気に霧状の水を噴霧して冷却した空気をデータセンターに壁の側面からファンで直接取り込む配管レスの外気冷却を採用した。同社によれば、こうした技術の導入によって同社の他のデータセンターよりも電力使用量を38%効率化したとする。

一方、日本でも新設の大規模データセンターでは、PUEが1.1台を示すところが登場している。例えば、さくらインターネットが2011年11月に稼働を開始した「石狩データセンター」(北海道石狩市)では、外気冷却の導入などで年間を通してのPUEを1.11にする目標を掲げている。

様々な先端的な取り組みから見ると、今後、データセンターの使用電力の削減に向けた技術導入は、(1)高効率空調、(2)外気冷却、(3)直流給電、(4)再生可能エネルギーの導入、の4項目で進みそうだ。

第3部<ストレージ編>

主役は超高速のSSD

DRAMとの性能差を埋める

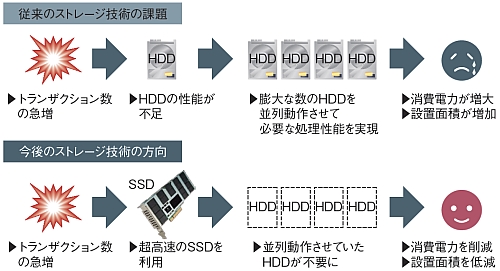

データセンターのストレージでは、いわゆる「SSD化」が急速に進んでいる。特にサーバー内のHDDを高速のSSDに置き換えることで、サーバーの処理能力を高め、サービスに必要なサーバー台数を大幅に削減する手法が注目を集めている。

「高速のSSDを使えば、サーバーの台数を1/10にできる。これに気付いたサービス事業者が、こぞってデータセンターにSSDを導入し始めた」。あるSSDベンダーの技術担当者は、データセンター向けのストレージ分野で起きている変化をこのように語る。

SSDそのものは高価でも、データセンター全体で考えれば、大幅な低コスト化、低消費電力化が可能になることから、データセンターの「SSD化」が猛烈な勢いで進み始めている。

データセンターにおけるSSD化の流れは、少なくとも今後数年は続くとみられる。さらに、より高速なSSDを目指し、媒体に現状のNANDフラッシュ・メモリよりも高速・長寿命な新型不揮発性メモリを利用する動きも出てきた。

第4部<ネットワーク編>

400Gビット/秒は射程内

休眠回線の活用で容量増大

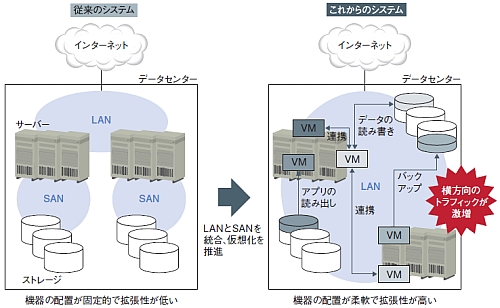

サーバー仮想化の結果、データセンター内で発生する通信が増大している。これに対処すべく開発が進められ、400Gビット/秒までの高速化が見えてきた。バックアップ用の回線をフル活用して帯域を増やす動きも活発化している。

データセンターの高効率化を図るため、サーバーの仮想化が進んでいる。仮想化することで、複数のサーバー・マシンで動作するソフトウエアを一つのサーバー・マシンに集約したり、ソフトウエアにとって最適なリソースを動的に割り当てたりできるためだ。だが、仮想化に伴い、データセンター内部のLANに流れる通信量が爆発的に増えている。

さらに最近では、従来はSAN(storage area network)として別に設けられていたバックアップ・ストレージ用のネットワークも、LANに統合されつつある。システムの簡素化のためだ。その結果、ますますLANの帯域が消費され始めている。

このデータセンター内LANでの通信量激増に対応しようと、今、大きく二つの方向の取組みが進んでいる。一つは1本のケーブルに流せるデータ量を向上させるという取り組み。もう一つが、冗長化のために用意されていた回線も使って帯域を拡大する取組みである。

第5部<マイクロプロセサ編>

スピードよりも効率重視

“スモールコア”を活用へ

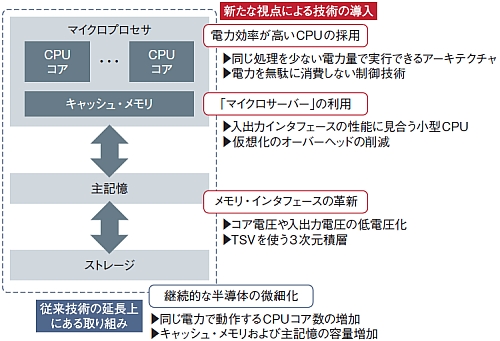

マイクロプロセサは、サーバー内で最も多くの電力を消費している。微細化の継続だけでは、電力効率の向上に対する要求を満たせない恐れがある。処理負荷の傾向に合わせて多様なCPUを選択する時代が到来している。

データセンターの単位消費電力当たり処理性能(以下、電力効率)の向上に対する要求は、サーバーのマイクロプロセサにも変化を迫る。電力効率が高いCPUコアを使ったり、演算性能とデータ入出力性能のバランスを取ったりすることによって、データセンター全体の電力効率向上に貢献していく。

マイクロプロセサの微細化によるコア数の増加や低電圧化、電圧や動作周波数の動的な制御で電力の無駄使いを減らす工夫などは、もちろん今後も継続する。そうした改善に加え、一部のサーバーのマイクロプロセサで、小型のCPUコアへの切り替えが始まる見通しだ。これまでデータセンター向けサーバーの市場では米Intel社の「Xeon」が支配的だったが、その状況が崩れそうだ。

例えば、米Hewlett-Packard社(以下、HP社)は「小型のCPUコアを使うサーバーが、2015年には全世界のサーバー市場の10~15%を占めるようになると試算している」という。