第1部<総論>

生活に溶け込んだ

幾多の機械が人を手伝う

人が自然に過ごしていると適切にアシストしてくれる“やさしい機械”が生活に溶け込み始める。人や周りの環境を読み取り、人を邪魔しない形で動く技術がそろいつつあるからだ。もう、人が機械に合わせる必要はなくなる。

人が機械の存在を意識しなくても、機械が適切な場面で適切なアシストをしてくれる──。そうした未来が間近に迫っている。

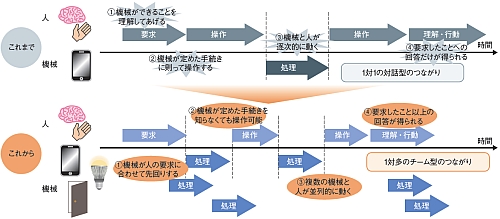

これまでの機械のほとんどは、人に1対1で向き合って対話することを強制してきた。常に人が起点になって「機械に何ができるか」を考え、機械ごとに定められた手続きに従ってボタンや画面を注視しながら操作しなければならなかった。ジェスチャーや音声で機械に意図を伝える新しいユーザー・インタフェースも拡大しつつあるが、ボタンやタッチ・パネルなどで入力していた内容を置き換えるだけにとどまっているのが現状だった。

これから到来するのは、人と機械の関係の大きな変化だ。人や周りの環境を適切に読み取り、人に迷惑にならない形で情報の提示や行動の誘導を行う技術が出そろいつつあるからだ。人と機械の境界が曖昧になり、人の行動に応じて同時並行で複数の機械が動作するようになる。目指すは、気が利く“やさしい機械”の遍在と協調だ。

“やさしい機械”を考え続ける

例えば、家の中で人が部屋に入ったとき。これまでは人感センサで照明をオンにするところまでだったが、部屋の中で人がどんな行動をしているかによって照明条件を最適化できるようになるだろう。人の入室を検知して動き始めたエアコンは、人の居場所や体表温度、発汗状態などを監視しながら、その人にとって最適な体感温度を保つように最小限の電力消費で動作する。さらに部屋の中で椅子に座ろうとしたときには、家族の中の誰が座ろうとしているのかを識別して事前に高さを調整してくれるだろう。

では、やさしい機械とは、どのような形をしていて、どのような機能を備えているのか──。そこに明確な定義はまだない。そうした機械を創造していく競争が、今まさに始まろうとしているのだ。加えて、人と機械の間をつなぐ技術の急速な進化によって、機械の姿はどんどん変わっていく。人の生活をより豊かに、より快適にするための機械の新たなあり方を探り続けることになる。エレクトロニクス業界がなすべきことは、まだまだたくさんある。

第2部<人を知る>

カメラや生体センサを使って

人の感情や振る舞いを把握

人の感情や振る舞いを理解してくれる機械──。これが、人と機械が共生する未来の創造に向けた第一歩だ。カメラや生体センサなどの新たなセンサの活用が不可欠となる。

人と機械の共生に向けて必要となるのが、機械が人の感情や振る舞いをより理解することだ。「ユーザーが必要とするタイミングで情報を提示しなければ意味がない」(オリンパス 未来創造研究所 研究コーディネータの龍田成示氏)からだ。このためには、人から機械への入力を大きく変える必要がある。

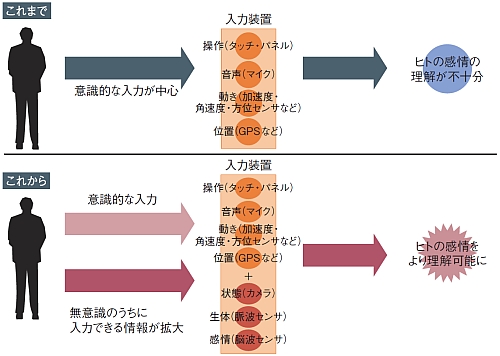

これまでは、人が機械に対して働きかける際には、意識的に入力をするのが一般的だった。スマートフォンの登場により、機器にタッチ・パネルや加速度センサといった各種センサの搭載が進んだものの、その多くは機器を操作する際の入力形態を変化させたにすぎない。

今後は、こうした意識的な人の行為ではなく、人が無意識のうちに機械が人の感情や振る舞いをより理解していくことが求められる。このためには、機器に搭載された既存のセンサ類の活用だけでは不十分だ。センサの種類そのものを増やし、顔の表情や手の動きなどの視覚的な情報や、脈波や脳波などの生体情報を計測し、人の感情や振る舞いを推測していくことが重要だ。

現在、ヘッドマウント・ディスプレイ(HMD)などのウエアラブル機器に、カメラや脈波センサを搭載する開発が着々と進んでいる。さらにウエアラブルな脳波センサで人の感情を測定できるようになってきた。

第3部<人を動かす>

感覚器へ直接訴えて

人機一体化を目指す

現在の機械から人への情報提示はディスプレイへの文字や記号、音に頼っている。しかし、この提示方法は人が意識を向けていないと有効ではない。新たな提示方法として、感覚器に直接訴えかけて人の感覚を拡張する研究が進められている。

半導体やセンサ技術の進化によって、機械が人を知り、支援できる範囲が広がっている。しかし、機械から人への情報の伝達方法は、現在においても記号や文字、音が中心だ。

こうした情報の提示方法は、利用する環境や場面によっては必ずしも人に優しいとはいえない。文字や記号、言語を理解することを人に強いるからだ。

例えば、スマートフォンの地図アプリ。GPS受信器の搭載などによって地図画面上に自分の位置や移動経路などは表示されるようになった。だが、今自分がどの方向を向いているのか、特に初めて訪れた場所の場合、どの角を曲がればよいのか戸惑ってしまう。さらに、考え事をしながら歩いている際など、意識的に情報を読み取ろうとしていないときに、情報を提示されても、それを理解するのは難しい。

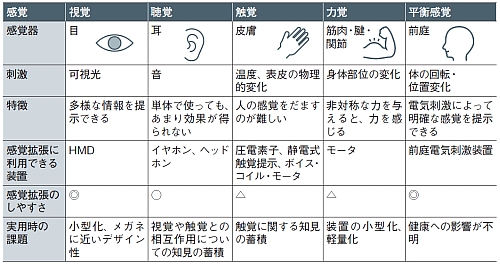

こうした課題に応えるため、現在、研究開発が盛んになってきているのが、人の感覚器に直接訴えるようなユーザー・インタフェース(UI)である。大阪大学 教授の前田太郎氏は「人は体を通して外界を認識する。外界からの刺激を機械で処理を施した後、人の感覚器に入力してあげれば、機械が人を自然にアシストすることができるようになる」と、新しいUIの開発の方向性を語る。つまり、人が記号や文字、言語を理解しなくても、人の知覚に直接働きかけて目的を達するといったことを目指そうというのだ。

こうしたUIのために使える感覚器として、現在検討が進んでいるのが視覚、聴覚、触覚、力覚、平衡感覚の五つである。