|

“脳で操る”新しいインタフェース |

|

ホンダとATRがロボットハンドでジャンケン動作を再現 |

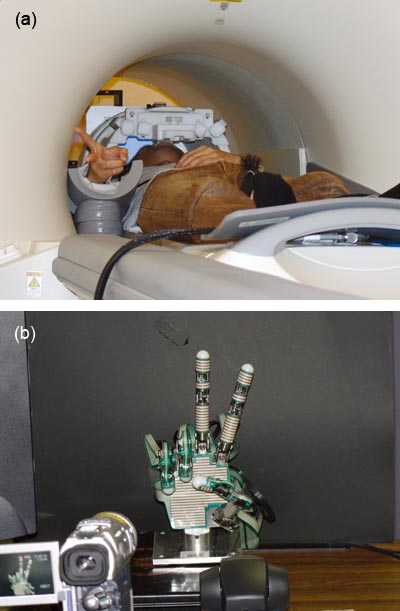

「グー」「チョキ」「パー」。MRI(磁気共鳴画像装置)の中に横たわった被験者が右手でジャンケンの動作を繰り返す。それに応じて,ロボットハンドがグー/チョキ/パーと,被験者の動作を再現する(図)。

被験者,いやロボットの操縦者は,ロボットに直接的な命令を一切与えない。右手でジャンケンのまねをするだけだ。そのときの,被験者の脳活動によって生じる脳内の血流変化をMRIで検出,その脳活動の意味するものを制御装置側で解読し,解読結果をロボットに送る。脳でロボットや機器を操る―ホンダ・リサーチ・インスティチュート・ジャパン(本社埼玉県和光市)と国際電気通信基礎技術研究所(ATR,本社京都府・精華町)は共同で,そうした未来のヒューマン・マシン・インタフェース(HMI)の実現を予感させるBMI(Brain Machine Interface)の基礎技術を開発した。

粗い画素を組み合わせて解読

両社が開発した今回のBMI技術では,制御装置となる汎用のパソコンに組み込む解読アルゴリズムが核となっている。この解読アルゴリズムは,MRIでとらえた脳内の血流変化の画像から,被験者がグー/チョキ/パー/脱力のいずれの動作を行っているのか解読するものである。

これらそれぞれの動作において,脳内の血流変化のパターンは異なる特徴を示す。その特徴に注目して,被験者の動作を解読しようというものだ。

そうした特徴は人によって異なる。その上,MRIでは各画素(ボクセル)が3×3×3mmと大きく,低い空間分解能でしか血流変化をとらえられない。この程度の分解能では脳内の神経細胞一つひとつの変化を把握することはできないため,従来はMRIでとらえた粗い画像から脳活動を解読することは難しいと考えられていた。

図●MRIを利用しロボットハンドを操作

(a)のようなMRI装置の中に横たわった被験者がジャンケンの動作を行うと,(b)のようにロボットハンドがその動作を再現する。